1. 概述與目標

為構建XX集團統一、高效、可信的數據資產體系,提升數據驅動決策能力,本方案聚焦于數據治理體系中的核心環節——數據處理服務。數據處理服務旨在通過標準化、自動化、智能化的技術手段,對原始數據進行采集、清洗、轉換、整合與加工,形成高質量、可復用的數據產品與服務,為上層數據分析、應用與決策提供堅實的數據基礎。

核心目標:

1. 提升數據質量: 建立端到端的數據質量管控流程,確保數據的準確性、完整性、一致性與時效性。

2. 實現數據標準化: 統一數據定義、口徑和模型,消除數據孤島,促進跨部門、跨系統數據共享與融合。

3. 提高處理效率: 通過自動化流水線與彈性計算資源,縮短數據處理周期,響應快速變化的業務需求。

4. 保障數據安全與合規: 在數據處理全生命周期嵌入安全策略,滿足數據安全法與行業監管要求。

5. 賦能數據應用: 構建面向主題、易于使用的數據服務層,直接支撐精準營銷、風險控制、運營優化等業務場景。

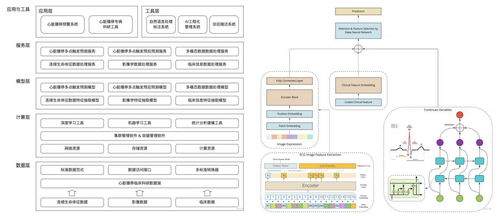

2. 總體架構設計

數據處理服務作為數據治理平臺的核心引擎,采用分層解耦、服務化的設計思想,其總體架構如下:

┌─────────────────────────────────────────┐

│ 數據應用層 (Data Application) │

│ (報表、分析、風控、營銷等業務場景) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 數據服務層 (Data Service API) │

│ (主題數據服務、指標服務、標簽服務、查詢服務) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 數據加工層 (Data Processing) │

│ (ETL/ELT、流處理、數據開發平臺、任務調度) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 數據存儲層 (Data Storage) │

│ (ODS、數據倉庫DW、數據湖、數據集市DM) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 數據集成層 (Data Integration) │

│ (實時采集、批量同步、API對接、日志收集) │

└─────────────────┬─────────────────────────┘

│

┌─────────────────▼─────────────────────────┐

│ 數據源層 (Data Sources) │

│ (業務系統、IoT設備、外部數據、文件等) │

└─────────────────────────────────────────┘各層核心功能:

- 數據集成層: 負責從異構數據源(如ERP、CRM、MES、日志、第三方API)進行全量及增量數據采集,支持實時流與批量兩種模式。

- 數據存儲層: 構建貼源數據層(ODS)、統一數據倉庫(DW)、數據湖(存儲原始數據與半結構化數據)以及面向業務線的數據集市(DM),形成層次清晰的數據存儲體系。

- 數據加工層: 核心處理單元。基于可視化或代碼化的數據開發平臺,完成數據清洗(去重、糾錯、標準化)、轉換(粒度轉換、維度退化)、關聯、聚合、復雜計算等任務,并通過統一調度系統有序執行。

- 數據服務層: 將加工后的標準化數據封裝成API、數據文件、消息等形式的服務,提供統一的數據訪問接口,實現數據與應用的解耦。

- 數據應用層: 直接消費數據服務,驅動各類業務場景。

3. 核心數據處理服務模塊

3.1 數據開發與調度平臺

- 可視化開發: 提供拖拉拽方式配置數據清洗、轉換規則,降低技術門檻。

- 腳本開發: 支持SQL、Python、Spark等腳本開發,滿足復雜邏輯需求。

- 任務編排: 圖形化編排處理任務間的依賴關系,形成數據處理流水線(DAG)。

- 智能調度: 支持時間、事件、依賴等多種觸發方式,具備失敗重試、告警、優先級管理等功能。

- 版本管理與協作: 實現數據處理任務的版本控制、發布上線與團隊協作開發。

3.2 批流一體處理引擎

- 批量處理: 針對海量歷史數據、T+1業務數據,采用分布式計算框架(如Spark、Hive)進行高效處理。

- 實時流處理: 對接Kafka、Pulsar等消息隊列,使用Flink、Spark Streaming等引擎處理實時數據流,滿足監控、實時風控等場景的秒級/毫秒級延遲要求。

- 統一API: 探索使用批流一體API(如Flink Table API),實現同一套邏輯對靜態數據和動態流數據的處理,簡化開發運維。

3.3 數據質量管理服務

- 質量規則庫: 預置及自定義完整性、有效性、準確性、一致性、唯一性、及時性等六大類質量規則。

- 流程嵌入: 在數據處理的關鍵環節(接入、清洗、加工、輸出)設置質量檢查點,實現“事前預防、事中監控、事后評估”。

- 質量監控與報告: 實時監控數據質量指標,生成質量報告與評分,并自動觸發告警或攔截流程。

- 質量整改閉環: 建立質量問題發現、派單、整改、驗證的閉環管理流程。

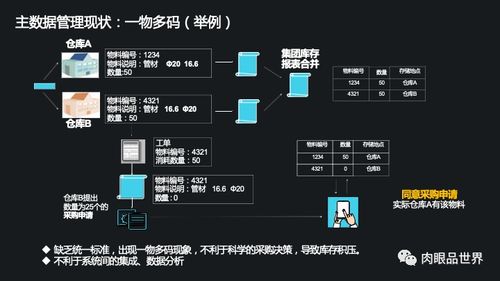

3.4 主數據與參考數據管理服務

- 主數據管理: 對客戶、供應商、產品、組織等關鍵業務實體,實現全集團統一的編碼、屬性定義、生命周期管理和分發同步。

- 參考數據管理: 統一管理國家代碼、行業分類、狀態碼等標準代碼,確保各系統引用一致。

3.5 數據服務化與API管理

- 服務封裝: 將數據表、視圖、預計算指標、用戶標簽等,封裝成標準的RESTful API或GraphQL接口。

- API網關: 統一接入、認證、鑒權、限流、監控和日志記錄。

- 服務目錄: 提供可視化的數據服務目錄,方便業務人員查找、理解和申請使用。

- 計量與計費: 支持對API調用量的統計,為內部成本分攤提供依據。

4. 實施路線圖(建議)

第一階段:基礎搭建與試點(1-6個月)

1. 搭建大數據基礎平臺(存儲、計算資源)。

2. 部署數據集成工具,完成1-2個核心業務系統的數據全量接入。

3. 上線數據開發與調度平臺,構建首個主題數據模型(如客戶主題)。

4. 在試點業務線(如營銷部門)提供初步的數據服務API。

第二階段:體系完善與推廣(7-18個月)

1. 完善數據倉庫分層模型,接入主要業務系統數據。

2. 全面部署數據質量管理模塊,建立常態化的質量巡檢機制。

3. 建立主數據管理體系,解決關鍵數據一致性問題。

4. 推廣數據服務API至更多業務部門,支撐3-5個典型數據應用場景。

5. 引入實時流處理能力,滿足實時業務需求。

第三階段:智能化與價值深化(19-36個月)

1. 探索AI在數據清洗、關聯發現、異常檢測等方面的應用。

2. 深化數據服務,提供預測性、建議性的智能數據服務。

3. 建立完善的數據資產運營體系,衡量數據服務帶來的業務價值。

4. 形成數據驅動的文化,數據處理服務成為集團業務創新與運營的核心支撐。

5. 保障措施

- 組織保障: 明確數據處理服務的歸口管理團隊(如數據平臺部),與業務部門、數據治理委員會緊密協同。

- 技術保障: 選擇成熟、開源或商業的技術棧,保證平臺的穩定性、擴展性和可維護性。建立容災備份與監控體系。

- 管理保障: 制定并落實《數據處理服務開發規范》、《數據質量管理辦法》、《數據服務API管理規范》等制度。

- 安全與合規保障: 嚴格執行數據分類分級,在數據處理各環節實施加密、脫敏、訪問控制等安全策略,定期進行合規審計。

通過本方案的實施,XX集團將構建起一個敏捷、可靠、智能的數據處理服務體系,使數據得以高效、安全地轉化為核心資產,為集團的數字化轉型與智能化升級注入強大動力。